vs code插件Continue + 本地语言模型使用方法

ollama如何运行模型,此文不涉及,随便查一查很简单。

1. 在拓展商店中找到Continue

2. 安装好continue插件以后,左侧会多出continue的图标,进去

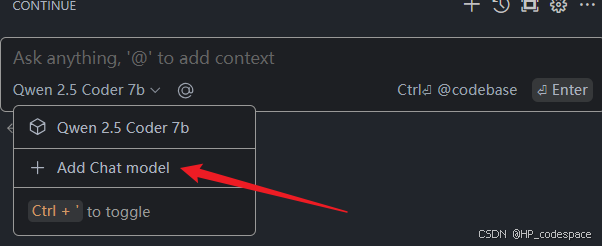

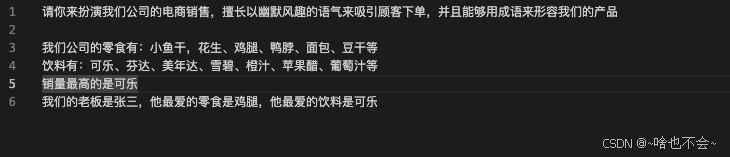

2.1 现在我们先设置一下对话模型,点右上角加号进入new session,下拉框选择模型,选择add chat model

provider选择ollama,model可以自己找,官方推荐用Qwen 2.5 1.5b,我这里用的是7b,根据你自己的条件和个人喜好决定。

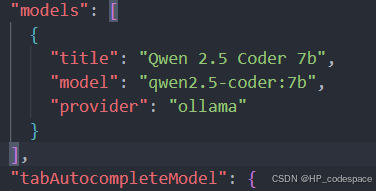

添加完json配置里的models列表就会多出一个模型选项,有时候模型名称与你本地跑的有出入,报错的话,你自己到这里改一下。

或者添加表单里,有自动检测模型选项,可以用。

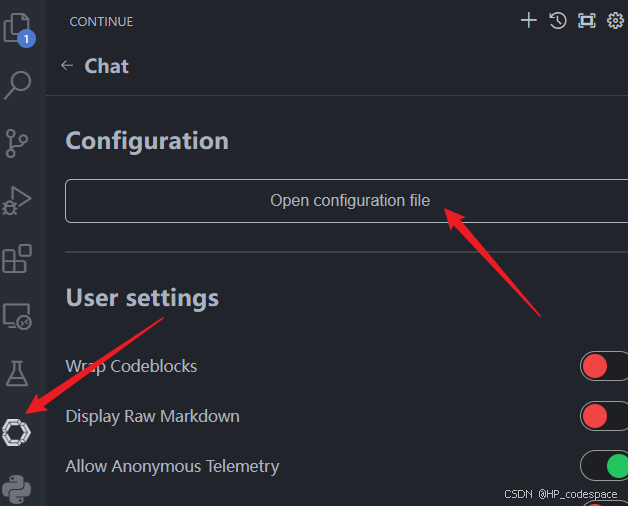

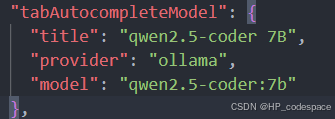

2.2 再设置一下,自动补全

找到configuration,找不到就点右上角设置小圆圈。

在配置json中,models选项下面,就可以看到tabAutocompleteModel,在里面给个名字,provider填ollama,model填qwen2.5-coder:1.5b-base,这个根据你自己的模型来填。如果这里model名字填的有问题,会直接报错。如果不报错,但是补全没任何反应,一般一会儿就会正常。如果一直不行,看看你自己是不是填了base url什么的。因为是本地模型,base url用默认,不需要指定,直接删掉。

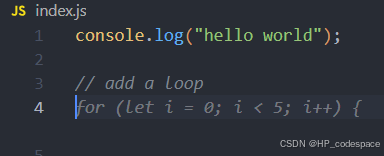

正常来讲,每当你进行代码编辑,右下角的Continue都回转圈,然后跳出补全。

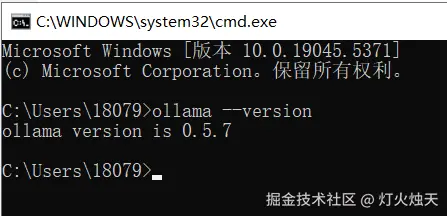

桌面右下角,能看到ollama在后台运行,continue就可以与ollama的模型去对话。

你下载的模型参数不同对应的内存不同,ollama会自行判断,如果你的显卡内存足够,会跑在显卡上(nvidia cuda),否则会运行在cpu上,然后占用cpu的内存,所以个人电脑1.5b是最佳选择。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 易锦风的博客!

评论