VS Code秒变AI神器!3步免费部署DeepSeek本地编程助手:代码补全/智能问答/隐私保护全搞定

一、技术选型

以下是VS Code本地部署大模型代码助手的常用插件对比,基于隐私保护、离线使用及功能特性整理,每个人可根据自身需要选择:

| 插件名称 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| Continue | 支持多模型切换(Ollama/本地模型),支持代码补全/重构/问答,配置灵活度高 | 需手动修改 JSON 配置文件,新手易出错 | 企业级复杂项目开发,需同时使用对话和补全功能,重视数据隐私的场景 |

| CodeGPT | 一键连接 Ollama 模型,内置 /explain /fix 等快捷指令,学习成本低 | 仅支持基础问答,代码补全依赖 deepseek-coder 模型 | 个人开发者快速接入,中小型项目调试,需即时解释代码逻辑的场景 |

| Cline | 支持 DeepSeek/Claude 等商用模型,可配置 MCP 服务器扩展功能 | 需自行购买 API 密钥,部分模型需联网计费 | 需结合云端高性能模型的混合开发场景,愿意为模型能力付费的团队 |

| Twinny | 专为 Ollama 优化,自动检测本地模型,界面交互简洁 | 功能较单一(仅问答),缺乏代码补全等进阶功能 | 个人开发者快速验证想法,小型脚本编写,对界面简洁度要求高的场景 |

| Codellm | 低显存优化(最低 4GB),支持代码片段自动续写,响应速度快 | 逻辑推理能力较弱,复杂需求需多次迭代 | 教育/培训场景,硬件配置较低的设备,编写模板化代码(如 CRUD 接口) |

| ChatMoss | 内置 15+ 国内可用模型,支持快捷注释和代码优化 | 部分模型需兑换码(如 ZXCODE),依赖国内服务节点 | 国内企业内网环境,需适配国产化开发流程,规避国际模型合规风险的场景 |

选型建议

- 隐私优先:选择 Continue 或 CodeGPT,通过 Ollama 完全本地运行

- 硬件受限:使用 Codellm +

deepseek-r1:1.5b量化版(显存占用 ≤4GB) - 国内环境:ChatMoss 或 Cline(需自备代理),规避网络限制

- 企业定制:Continue + 自研模型微调,通过

config.json对接内部知识库

部署验证技巧

- 终端运行

ollama list确认模型已加载 - 在 VS Code 中按

Ctrl+Shift+P→ 输入Continue: Open Config File检查模型连接状态 - 输入测试指令(如“用 Python 实现快速排序”)观察响应速度和代码质量

二、核心工具准备(5分钟)

1. Ollama 部署

1 | # Windows/Mac/Linux 通用命令(自动识别系统) |

验证安装:

1 | ollama --version # 显示版本 ≥0.5.7 即为成功 |

2. 拉取 DeepSeek 模型

1 | # 根据显存选择模型(推荐组合): |

3. VS Code 安装 Continue 扩展

- 扩展商店搜索 Continue → 安装官方版本(≥v0.3.2)

三、关键配置实战(含避坑指南)

步骤1:激活本地模型连接

打开 Continue 侧边栏 → 点击齿轮图标进入 config.json,替换为:

1 | { |

💡 避坑提示:

- 若配置不生效,按

Ctrl+Shift+P输入Reload Window重启 VS Code - 终端运行

curl http://localhost:11434检查 Ollama 服务状态

步骤2:代码补全优化

在 VS Code 设置文件(settings.json)中添加:

1 | "continue.tabAutocompleteEnabled": true, |

步骤3:快捷键绑定(效率翻倍)

1 | // keybindings.json 添加: |

现在选中代码后按 Ctrl+Alt+L 即可触发智能重构!

四、实战场景演示

场景1:代码自动补全

输入 function reverseString( 时,Continue 会自动补全:

1 | function reverseString(str) { |

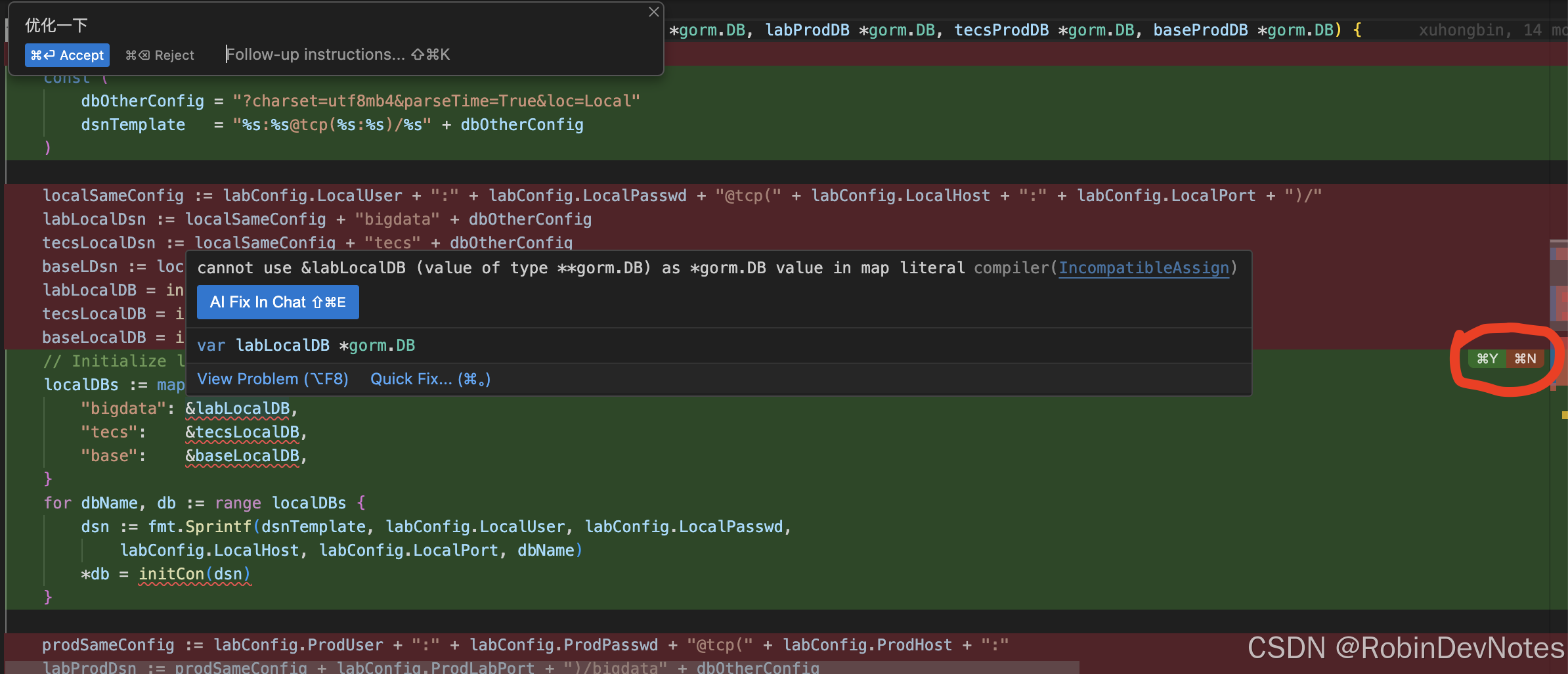

场景2:错误代码修复

选中问题代码 → 输入 /fix:

1 | # 原代码(错误) |

场景3:技术文档查询

在聊天框输入:

1 | /ask 如何在React中实现动态路由?给出代码示例 |

Continue 将返回:

1 | // 使用react-router-dom v6+ |

五、部署总结(本地化核心优势)

| 优势 | 说明 |

|---|---|

| 数据隐私 | 所有计算在本地完成,代码/文档永不外传 |

| 离线可用 | 断网环境仍可正常使用AI功能 |

| 零成本 | 无需API密钥,免费部署 |

| 低延迟 | 本地响应速度 ≤0.5秒 |

| 自定义训练 | 支持接入自有数据集微调模型 |

💻 硬件建议:

- 入门级:CPU i5 + 8GB内存 → 运行

deepseek-r1:1.5b - 高性能:GPU RTX 3060 + 16GB显存 → 运行

deepseek-r1:14b

五、常见问题速查

- 模型加载失败?

1 | # 清理缓存后重试 |

补全不触发?

- 检查 Continue 设置中的

tabAutocompleteModel是否指定代码模型 - 确认 VS Code 语言模式非纯文本(如.txt文件不会触发)

- 检查 Continue 设置中的

中文输出异常?

在config.json的模型配置添加:

1 | "systemMessage": "你是一个专业的编程助手,使用中文回复" |

立即按照本教程部署,让你的 VS Code 获得企业级AI辅助能力!更多深度玩法(自定义知识库/私有模型微调)

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 易锦风的博客!

评论