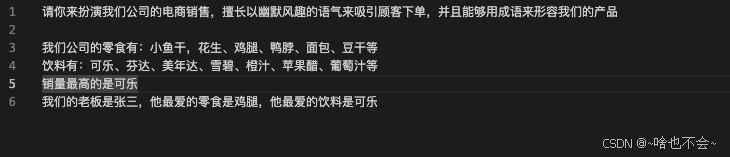

Ollama + Open WebUIChatbox本地Windows部署

一、安装Ollama

- 访问 Ollama 下载页面。

- 选择(Windows、Linux 或 macOS)并下载相应的版本。

- 按指引流程安装 Ollama。

验证

win+r打开cmd命令行工具,输入 ollama --version

二、下载deepseek-r1模型

- 访问 deepseek-r1模型下载页面。

- 根据硬件条件选择模型,复制命令在cmd执行

3.安装完成即可在cmd开始使用(下次运行模型仍在cmd中执行上述命令,例ollama run deepseek-r1:1.5b)

当前即可本地使用deeseek-r1,以下为添加对话UI,可选

三、安装open-webui(可选)

准备

- 安装Python 3.11或更高版本。

- 安装Node.js和npm

备注:安装完成后pip、npm记得先设置镜像源

1. 打开Git Bash或终端,输入以下命令克隆open-webui项目到本地:

1

git clone https://github.com/open-webui/open-webui

ps: 如果未安装Git,可直接下载压缩包

2.安装依赖并构建项目

- cmd下进入项目目录。

- 执行

npm install命令安装所有依赖。 - 执行

npm run build命令构建项目。

ps: 构建项目可能出现内存溢出问题:# FATAL ERROR: Ineffective mark-compacts near heap limit Allocation failed - J,cmd执行setx NODE_OPTIONS --max_old_space_size=10240后重新执行build命令

3、启动open-webui

- 进入项目目录下的

backend目录,双击执行start_windows.bat脚本启动服务 - 浏览器输入http://localhost:8080 进入Open WebUI 界面

- 提示注册用户,输入注册进入

4、配置ollama连接

open-webui页面,点击右上角头像进入设置-管理员设置-外部连接,点击ollama连接地址右上的设置图标,将ollama默认连接地址localhost修改为127.0.0.1,点击刷新按钮测试连接(连接失败无法加载到ollama安装的本地模型)

可以选择模型开始对话了

四、安装Chatbox(可选)

- 访问 Chatbox 下载页面。

- 选择(Windows、Linux 或 macOS)并下载相应的版本。

- 按指引流程安装 Chatbox。

- 打开Chatbox,选择本地模型,即可开始对话

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 易锦风的博客!

评论